Künstliche Intelligenz (KI) revolutioniert unsere Welt in rasantem Tempo. Doch der Fortschritt hat seinen Preis: KI-Anwendungen benötigen immense Rechenleistung und verschlingen enorme Mengen an Energie. Rechenzentrumsbetreiber stehen vor der Herausforderung, die steigende Nachfrage nach KI-Kapazitäten zu bedienen und gleichzeitig den Energieverbrauch und die Umweltbelastung zu minimieren. Könnte Compute Express Link (CXL) die Lösung sein? Diese noch recht junge Verbindungstechnologie verspricht eine effizientere Nutzung von Speicherressourcen und eine Reduktion des Energieverbrauchs. Doch ist CXL wirklich der Schlüssel zu einer nachhaltigen KI-Zukunft oder nur ein vorübergehender Hype?

Definition: Was ist CXL, und wie funktioniert es?

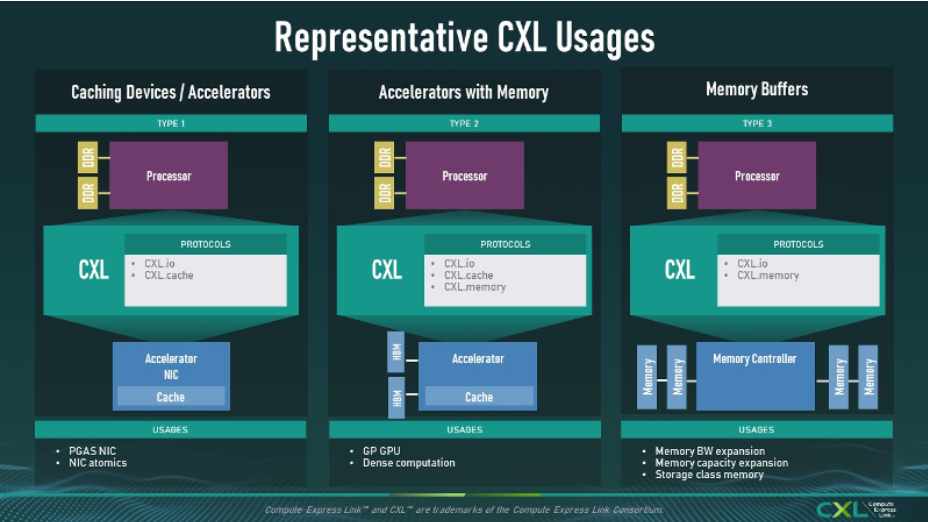

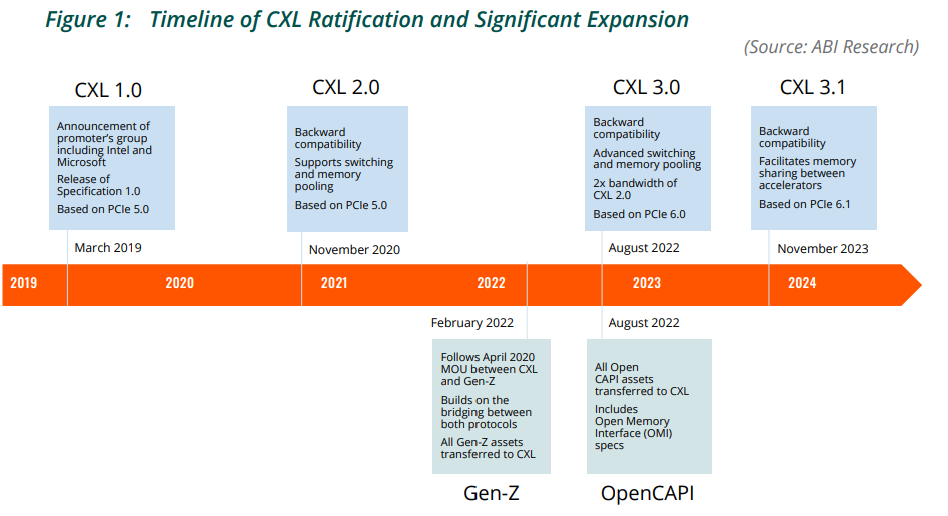

CXL (Compute Express Link) ist ein offener Standard für Verbindungstechnologien, die eine effiziente Kommunikation zwischen Prozessoren, Beschleunigern und Speichergeräten ermöglichen.CXL baut auf dem PCIe-Standard auf und erweitert diesen. Es ermöglicht die Erweiterung und das Pooling von Speicher über verschiedene Recheneinheiten hinweg, wie z.B. CPUs, GPUs und Beschleuniger.

Funktionsweise

CXL bietet eine cache-kohärente Breitbandverbindung zwischen verschiedenen Hardwarekomponenten wie GPU und Speicher. Anstatt Speicherressourcen an einen einzelnen Prozessor zu binden, wo sie oft ungenutzt bleiben, ermöglicht CXL die dynamische Zuweisung von Speicherplatz dorthin, wo er am dringendsten benötigt wird. Dadurch wird die Gesamtauslastung des Speichers erhöht, die Menge an ungenutztem Speicher in Rechenzentren reduziert und der Energiebedarf für die Aufrechterhaltung dieser Ressourcen gesenkt.

Ihr Wartungsspezialist im DataCenter

Strombedarf für Rechenzentren steigt

Die zunehmende Nutzung von KI führt zu einem exponentiell steigenden Strombedarf von Rechenzentren. Der Bedarf an Rechenleistung für KI-Anwendungen wie ChatGPT, Perplexity oder Google AI Overviews wächst so schnell, dass die Versorgung mit ausreichend Strom, insbesondere aus erneuerbaren Energiequellen, zu einem Problem wird. Obwohl Unternehmen wie Amazon, Google oder Microsoft zunehmend auf erneuerbare Energien setzen, reicht das Angebot oft nicht aus, um den Bedarf zu decken. Hinzu kommt, dass Rechenzentren rund um die Uhr Strom benötigen, was die Kapazitäten vieler erneuerbarer Energiequellen übersteigt. Um die Lücke zu schließen, greifen einige Unternehmen auf fossile Energieträger wie Gas oder sogar Atomkraft zurück, was jedoch negative Auswirkungen auf das Klima und die Umwelt hat.

CXL bietet eine Chance, den Stromverbrauch von KI-Rechenzentren zu reduzieren und die Effizienz zu erhöhen.

Per CXL den Energieverbrauch von Rechenzentren senken

CXL ermöglicht eine dynamische Verteilung und gemeinsame Nutzung der Speicherressourcen, sodass sie dort eingesetzt werden, wo sie am dringendsten benötigt werden. Dadurch wird die Menge an ungenutztem Speicher reduziert, was wiederum den Energieverbrauch senkt.

Hinzukommt die Reduktion des Kühlbedarfs. Auch ungenutzter Speicher erzeugt Wärme und muss gekühlt werden. Durch die effizientere Speichernutzung mit CXL wird weniger Wärme erzeugt, was den Kühlbedarf und den Energieverbrauch des gesamten Rechenzentrums reduziert.

CXL trägt auch dazu bei, die Gesamtzahl der benötigten Server zu reduzieren. Durch das Pooling von Speicherressourcen können mehr Workloads auf weniger Servern ausgeführt werden.

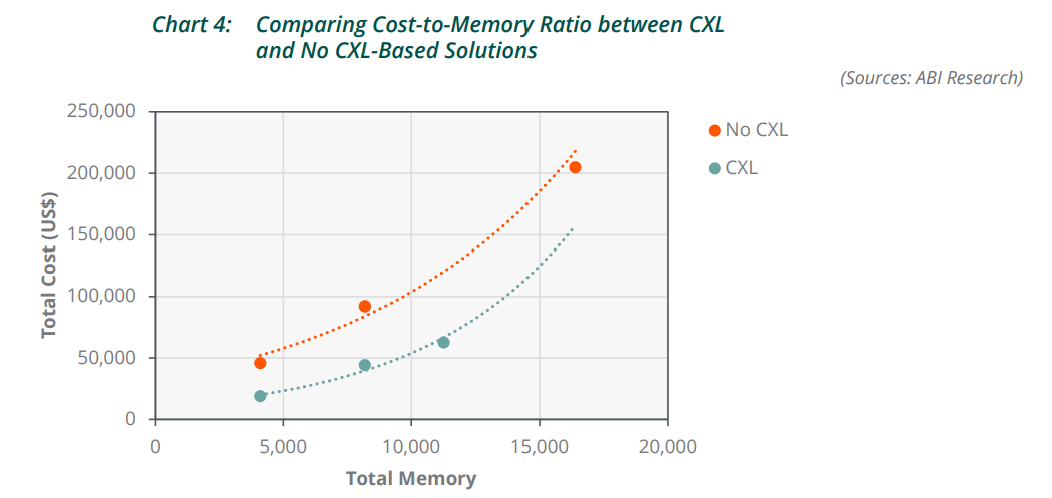

CXL ermöglicht die Erweiterung des GPU-Speicherpools, wodurch die Nutzung von High-Bandwidth Memory (HBM) maximiert wird. HBM ist eine besonders schnelle und leistungsstarke Speichertechnologie, die jedoch aufgrund ihrer hohen Kosten und begrenzten Verfügbarkeit nur sparsam eingesetzt werden kann. Durch die Erweiterung des HBM-Pools mit CXL können Unternehmen die Anschaffung zusätzlicher GPUs oder dichterem HBM vermeiden und somit erhebliche Kosten sparen

Dies führt außerdem zu einem geringeren Platzbedarf im Rechenzentrum und einem reduzierten Energieverbrauch für die Serverhardware.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Weitere Argumente für die Verwendung von CXL in KI-Rechenzentren

Ein weiterer wichtiger Aspekt ist die Flexibilität von CXL. Die Technologie ist nicht auf die GPU-zu-GPU-Kommunikation beschränkt, die in der generativen KI eine wichtige Rolle spielt. CXL kann auch für andere KI-Anwendungsfälle eingesetzt werden, die hohe Anforderungen an die Speicherkapazität und -bandbreite stellen. Ein Beispiel hierfür sind Vektor-Datenbanken, die große Datenmengen im Speicher halten müssen, um schnell auf Anfragen reagieren zu können. Durch die Speichererweiterung mit CXL können diese Datenbanken vollständig im Speicher gehalten werden, was ihre Geschwindigkeit und Effizienz deutlich erhöht.

Darüber hinaus kann CXL dazu beitragen, die DRAM-Auslastung in Rechenzentren massiv zu erhöhen. DRAM ist ein wichtiger Bestandteil von Serversystemen, wird aber oft nicht optimal genutzt. CXL ermöglicht eine effizientere Nutzung des DRAM, was zu erheblichen Kosteneinsparungen für Cloud-Anbieter führen kann.

Welche Probleme und Nachteile gibt es?

Trotz des Potenzials von CXL gibt es einige Hürden und Nachteile, die der breiten Akzeptanz dieser Technologie in KI-Rechenzentren entgegenstehen.

Ein zentrales Problem ist der Wettbewerb durch proprietäre Verbindungstechnologien, insbesondere NVLink von Nvidia. NVLink bietet eine höhere Bandbreite als CXL und ist speziell auf die Anforderungen von Nvidia-GPUs zugeschnitten. Da Nvidia im KI-Bereich eine dominante Stellung einnimmt, ist die Attraktivität von CXL für viele Unternehmen eingeschränkt.

Auch die begrenzte „Shoreline Area“ bei GPUs stellt eine Hürde für den Einsatz von CXL dar. Die „Shoreline Area“ bezieht sich auf den verfügbaren Platz am Rand eines Chips für die Integration von I/O-Verbindungen. Bei modernen GPUs wird ein Großteil dieser Fläche bereits von HBM-Speicher belegt. Dadurch bleibt weniger Platz für andere Schnittstellen wie PCIe, auf dem CXL basiert. Diese räumliche Beschränkung erschwert die Integration von CXL in GPUs.

CXL basiert auf PCIe-SerDes, die aufgrund ihrer strengen Latenzanforderungen ein weniger effizientes Fehlerkorrekturverfahren (FEC) verwenden als Ethernet-basierte SerDes. Dies führt zu einer höheren Latenz bei CXL im Vergleich zu NVLink oder anderen proprietären Lösungen. Für KI-Anwendungen, bei denen es auf massive Parallelisierung ankommt, spielt diese Latenzdifferenz zwar eine untergeordnete Rolle, dennoch kann sie in bestimmten Szenarien einen Nachteil darstellen.

Obwohl CXL ein offener Standard ist, ist die Unterstützung durch Hardwarehersteller noch nicht flächendeckend. Nvidia-GPUs unterstützen CXL derzeit nicht, und die Implementierung bei AMD ist noch begrenzt. Solange die wichtigsten GPU-Hersteller CXL nicht in vollem Umfang unterstützen, wird die Verbreitung dieser Technologie im KI-Bereich behindert.

Und schließlich ist die Integration von CXL in bestehende Rechenzentrumsarchitekturen komplex und erfordert Anpassungen an Hardware und Software. Die Implementierung neuer Standards und Protokolle kann zusätzliche Herausforderungen für die Systemverwaltung und -wartung mit sich bringen.

Bewertung und Handlungsempfehlung

Angesichts der genannten Vor- und Nachteile von CXL ist es für Betreiber von KI-Rechenzentren wichtig, keine voreiligen Entscheidungen zu treffen und die Entwicklung von CXL und alternativen Technologien genau zu beobachten.

Folgende Handlungsempfehlungen lassen sich ableiten:

Individuelle Bewertung der CXL-Relevanz

Anstatt blind dem Hype zu folgen, sollten Betreiber die spezifischen Anforderungen ihrer KI-Workloads analysieren und prüfen, ob CXL tatsächlich Vorteile gegenüber anderen Lösungen bietet. Faktoren wie die Art der KI-Anwendungen, die verwendete Hardware und die Budgetrestriktionen spielen hierbei eine entscheidende Rolle.

Fokus auf Energieeffizienz

Unabhängig von der Entscheidung für oder gegen CXL sollten Betreiber von KI-Rechenzentren die Energieeffizienz ihrer Infrastruktur priorisieren. Maßnahmen wie die Optimierung der Kühlung, die Nutzung erneuerbarer Energien und die Implementierung von Softwarelösungen zur Steigerung der Ressourcenauslastung können den Stromverbrauch und die Umweltbelastung deutlich reduzieren.

Langfristige Planung und Flexibilität

>Der KI-Bereich entwickelt sich rasant weiter. Betreiber von Rechenzentren sollten daher eine langfristige Perspektive einnehmen und sicherstellen, dass ihre Infrastruktur flexibel genug ist, um zukünftige technologische Entwicklungen zu integrieren. Das kann bedeuten, auf modulare Designs zu setzen und enge Partnerschaften mit Technologieanbietern einzugehen, um frühzeitig auf neue Trends reagieren zu können.

Beobachtung der Marktentwicklung

Die Verfügbarkeit und Unterstützung von CXL durch Hardwarehersteller ist ein entscheidender Faktor für den Erfolg der Technologie. Betreiber sollten die Entwicklungen im Markt genau verfolgen und ihre Entscheidungen auf Basis der aktuellen Situation treffen. Die Integration von CXL sollte erst dann in Betracht gezogen werden, wenn ausreichende Unterstützung durch die wichtigsten Hardwareanbieter gewährleistet ist und sich die Technologie als zuverlässige und kosteneffektive Lösung bewährt hat.

Serverwartung zum Bestpreis

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Server Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Stromnetz als Flaschenhals: Warum Rechenzentren zunehmend länger warten müssen

Während Unternehmen Milliarden in den Bau neuer Rechenzentren investieren, offenbart sich ein unerwarteter Engpass: der Anschluss an das Stromnetz.

#12 KI und Tech To Go – Der Praxis-Pitch

KI-Infrastruktur, Green IT, KI-Modelle, Anwendungen und der revolutionäre KI-Agent Manus AI Ein Überblick über die neuesten Entwicklungen in

Beschädigung des Peace-Unterseekabels im Roten Meer: erhebliche Störung des globalen Datenverkehrs erwartet

Das Peace Unterseekabel im Roten Meer wurde beschädigt. Die Folgen sind voraussichtlich monatelange Reparaturen und erhebliche Auswirkungen auf den

Zum Inhalt springen

Zum Inhalt springen