Google DeepMind setzt weiter auf den Ausbau seiner Hardwarekompetenzen in der KI. Mit der Verpflichtung von Maxence Ernoult, einem ausgewiesenen Experten im neuromorphic Computing, positioniert sich das Unternehmen für die nächste Entwicklungsstufe energieeffizienter und leistungsstarker Hardware-KI-Beschleuniger.

Maxence Ernoult, der zuvor mehr als zwei Jahre bei dem von Sam Altman unterstützten Start-up Rain AI tätig war, bringt umfangreiche Erfahrungen im Bereich des In-Memory Computing mit – einer Technologie, die darauf abzielt, die Arbeitsweise des menschlichen Gehirns nachzubilden. Neben seiner Tätigkeit bei Rain AI zählen auch Stationen bei IBM zu seinem beruflichen Werdegang, ergänzt durch ein Studium der neuromorphen Systeme an der renommierten Sorbonne Université. In einem enthusiastischen LinkedIn-Beitrag kündigte Ernoult seinen Einstieg als „Senior Research Engineer“ im AI-Hardware-Team von Google DeepMind an, was den ehrgeizigen Kurs des Unternehmens unterstreicht.

Neuromorphic Computing orientiert sich an Hirnstrukturen

Der Einsatz von neuromorphen Ansätzen ist nicht nur ein technologischer Fortschritt, sondern eröffnet auch neue Perspektiven zur Lösung aktueller Herausforderungen in der KI. Die Methode versucht, neuronale Strukturen und deren synaptische Prozesse in Hardware nachzubilden – ein Ansatz, der das Potenzial hat, den Energieverbrauch deutlich zu senken und gleichzeitig die Verarbeitungsgeschwindigkeit zu erhöhen. Gerade angesichts des rapiden Anstiegs des Leistungsbedarfs in modernen Rechenzentren sind solche Entwicklungen von großer wirtschaftlicher und ökologischer Relevanz.

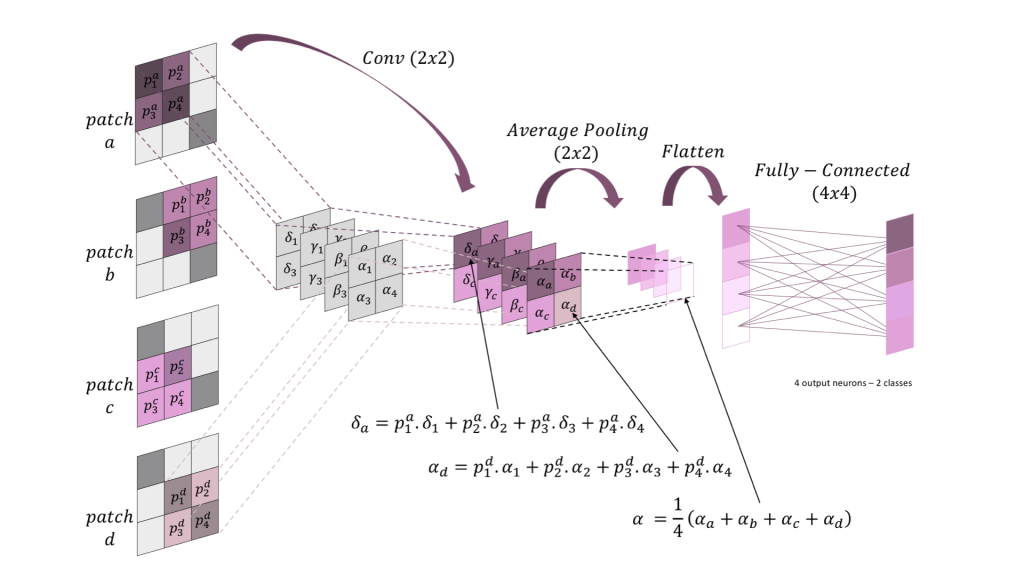

Ein Beispiel findet ihr in folgender Darstellung:

Erklärung zum Bild:

Grob gesagt zeigt das Bild einen kleinen „Baustein“ eines Neuronalen Netzwerks, das ähnlich wie bei klassischen Convolutional Neural Networks (CNNs) funktioniert. Man kann sich das folgendermaßen vorstellen:

-

Eingangs-Bild wird in Teilstücke (Patches) zerlegt

Ein kleines Bild wird in vier Bereiche („Patches“) aufgeteilt. Jeder Bereich besteht aus 2×2 Pixeln. Die Farben (Grau/Violett) zeigen, welche Pixel zusammengehören. -

Faltungs-Schritt (Conv)

Ein „Faltfilter“ (in der Regel ein kleines 2×2-Muster aus Gewichten) wird auf jeden Patch angewendet. Der Filter nimmt die Pixel im Patch und berechnet daraus einen neuen Wert pro Patch – man kann sich das wie eine spezielle Mustererkennung in jedem Teilbereich vorstellen. -

Pooling-Schritt (Average Pooling)

Danach wird das Ergebnis pro Patch noch vereinfacht (durchschnittlich zusammengefasst). Das heißt, mehrere Werte werden zu einem einzigen kleineren Wert verrechnet. Damit verringern wir die Datenmenge und fassen ähnliche Bereiche zusammen. -

Flatten

Alle diese „zusammengefassten“ Werte werden dann in einer langen Liste (Vektor) angeordnet, damit eine anschließende voll verbundene Schicht (Fully-Connected Layer) sie einfacher verarbeiten kann. -

Voll verbundene Schicht (Fully-Connected Layer)

In dieser Schicht ist jedes Element aus unserer Liste mit jedem Neuron hier verbunden. Anhand dieser Verbindungen berechnet das Netzwerk am Ende seine Ausgaben (z.B. für eine Klassifizierung in 2 Klassen: „ja/nein“ oder „Katze/Hund“). -

Warum neuromorph?

Neuromorphe Hardware versucht, all diese Rechenschritte – Faltung, Pooling, Zusammenrechnen – möglichst energiesparend in elektronischen Schaltkreisen abzubilden, oft in Form von „spikenden“ Neuronen oder anderen biologisch inspirierten Ansätzen. So kann man CNN-ähnliche Abläufe effizient in Hardware umsetzen.

Kurz gesagt: Das Bild zeigt, wie Daten aus einem Bild in kleinen Abschnitten (Patches) verarbeitet, zusammengefasst (gepoolt) und schließlich über eine Schicht voll vernetzter Neuronen klassifiziert werden – und das alles im Stil eines neuromorphen Systems.

Hardwareentwicklung wird per KI vorangetrieben

Parallel zu diesen Bemühungen investiert Google DeepMind auch stark in die Weiterentwicklung seiner bestehenden Hardwarearchitektur. Unter der Leitung von Forschern wie Albert Cohen und Olivier Temam – dem ehemaligen Mitentwickler der Tensor Processing Units (TPUs) – wird intensiv an neuartigen Systemen gearbeitet. Die TPUs, die nicht nur das Training, sondern auch die Inferenzprozesse in KI-Modellen unterstützen, spielen bereits eine zentrale Rolle in Googles Cloud-Services. Gleichzeitig treibt das AlphaChip-Projekt, bei dem künstliche Intelligenz zur Optimierung des kompletten Chip-Design-Zyklus eingesetzt wird, die Automatisierung und Effizienz im Hardware-Entwicklungsprozess weiter voran.

AlphaChip steht exemplarisch für den ehrgeizigen Kurs von DeepMind: Es soll sämtliche Phasen des Chip-Designs revolutionieren – von der Architektur über Logik-Synthese bis hin zur Fertigung. Obgleich derzeit noch unklar ist, inwieweit neuromorphe Techniken in diese Initiative integriert werden, deuten die Rekrutierungen und jüngsten Forschungsergebnisse darauf hin, dass Google DeepMind plant, Brücken zwischen konventionellen und neuartigen Ansätzen zu schlagen. Experten verweisen auf die Notwendigkeit, den Design-Prozess für KI-Hardware grundlegend neu zu denken, um die stetig wachsenden Anforderungen an Energieeffizienz und Rechenleistung zu erfüllen.

Neuromorphic Computing orientiert sich an Hirnstrukturen

Der Einsatz von neuromorphen Ansätzen ist nicht nur ein technologischer Fortschritt, sondern eröffnet auch neue Perspektiven zur Lösung aktueller Herausforderungen in der KI. Die Methode versucht, neuronale Strukturen und deren synaptische Prozesse in Hardware nachzubilden – ein Ansatz, der das Potenzial hat, den Energieverbrauch deutlich zu senken und gleichzeitig die Verarbeitungsgeschwindigkeit zu erhöhen. Gerade angesichts des rapiden Anstiegs des Leistungsbedarfs in modernen Rechenzentren sind solche Entwicklungen von großer wirtschaftlicher und ökologischer Relevanz.

Hardwareentwicklung wird per KI vorangetrieben

Parallel zu diesen Bemühungen investiert Google DeepMind auch stark in die Weiterentwicklung seiner bestehenden Hardwarearchitektur. Unter der Leitung von Forschern wie Albert Cohen und Olivier Temam – dem ehemaligen Mitentwickler der Tensor Processing Units (TPUs) – wird intensiv an neuartigen Systemen gearbeitet. Die TPUs, die nicht nur das Training, sondern auch die Inferenzprozesse in KI-Modellen unterstützen, spielen bereits eine zentrale Rolle in Googles Cloud-Services. Gleichzeitig treibt das AlphaChip-Projekt, bei dem künstliche Intelligenz zur Optimierung des kompletten Chip-Design-Zyklus eingesetzt wird, die Automatisierung und Effizienz im Hardware-Entwicklungsprozess weiter voran.

AlphaChip steht exemplarisch für den ehrgeizigen Kurs von DeepMind: Es soll sämtliche Phasen des Chip-Designs revolutionieren – von der Architektur über Logik-Synthese bis hin zur Fertigung. Obgleich derzeit noch unklar ist, inwieweit neuromorphe Techniken in diese Initiative integriert werden, deuten die Rekrutierungen und jüngsten Forschungsergebnisse darauf hin, dass Google DeepMind plant, Brücken zwischen konventionellen und neuartigen Ansätzen zu schlagen. Experten verweisen auf die Notwendigkeit, den Design-Prozess für KI-Hardware grundlegend neu zu denken, um die stetig wachsenden Anforderungen an Energieeffizienz und Rechenleistung zu erfüllen.

Ihr Wartungsspezialist im DataCenter

Durch Jahrzehnte lange Erfahrung wissen wir worauf es in Ihrem Data Center ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Leistungssteigerung und mehr Nachhaltigkeit

Die strategische Personalentscheidung, einen erfahrenen Neuromorphic-Computing-Experten ins Team zu holen, ist ein starkes Indiz für den intensiven Wettbewerb in der globalen Tech-Branche. Unternehmen wie Google DeepMind wollen nicht nur ihre eigenen Technologien weiterentwickeln, sondern auch den Standard für zukünftige KI-Lösungen setzen. Dabei spielt neben der reinen Leistungssteigerung auch die Nachhaltigkeit eine immer größere Rolle – ein Aspekt, der besonders in Zeiten steigender Energiepreise und wachsender Umweltbedenken zunehmend an Bedeutung gewinnt.

Weiterentwicklung der KI durch Innovationen bei Hardware und Software

Die nächste Ära der KI-Entwicklung wird maßgeblich von einer engen Verzahnung aus Softwareinnovation und Hardware-Exzellenz geprägt sein. Mit neuen Konzepten, die neuromorphe Ansätze und konventionelle Halbleitertechnologien miteinander verbinden, bereitet sich Google DeepMind darauf vor, die künftigen Herausforderungen des Machine-Learning-Betriebs nicht nur effizient, sondern auch nachhaltiger zu meistern.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

#18 KI und Tech To Go – Der Praxis-Pitch

"Bitte" zur KI, Topmodel-Flops und KI als Richter? Von "Bitte" zur KI-Richterin: Höflichkeit, Halluzinationen, KI-Kriegsführung und Revolutionen im

#17 KI und Tech To Go – Der Praxis-Pitch

Im Fokus: Google stellt das Agent2Agent-Protokoll für KI-Agenten vor Die Zukunft wird geprägt sein von kooperierenden KI-Agenten. Das

Höherer Energieverbrauch: Sollte man höflich zur KI sein?

Ein Post von OpenAI CEO Sam Altman hat Diskussionen zur Frage ausgelöst, ob ein höfliches “Bitte” und “Danke” gegenüber

Zum Inhalt springen

Zum Inhalt springen