Die wachsende Nachfrage nach Google’s Tensor Processing Units (TPUs) stellt eine potenzielle Herausforderung für die Marktdominanz von NVIDIA im Bereich der Grafikprozessoren (GPUs) dar.

Sowohl TPUs als auch GPUs eignen sich hervorragend für den Einsatz in KI-Projekten. Die Entscheidung zwischen TPUs und GPUs hängt von verschiedenen Faktoren ab, darunter den spezifischen Anforderungen des KI-Projekts, den bevorzugten ML-Frameworks, den Kosten und der benötigten Infrastruktur. TPUs sind ideal für große, komplexe Deep-Learning-Modelle mit vielen Matrixberechnungen und bieten eine hohe Energieeffizienz und Leistung für TensorFlow-basierte Projekte. GPUs hingegen sind vielseitiger und eignen sich für eine breitere Palette von Anwendungen, bei denen Flexibilität und Anpassungsmöglichkeiten von großer Bedeutung sind.

Broadcom, ein wichtiger Zulieferer von Google, Meta und anderen Unternehmen, hat laut dem Analystem OMDIA seine Umsatzziele für KI-Halbleiter für das laufende Jahr auf 12 Milliarden Dollar angehoben. Es wird geschätzt, dass Google’s TPUs zwischen 6 und 9 Milliarden Dollar davon ausmachen könnten, abhängig von der Aufteilung zwischen Rechen- und Netzwerkgeräten. Diese Zahlen deuten auf ein signifikantes Wachstum im TPU-Markt hin und verstärken die potenzielle Bedrohung für NVIDIA.

Um zu verstehen, warum Google TPUs die dominierende Stellung von NVIDIA in Frage stellen können, ist es wichtig, die Funktionsweise von TPUs, ihre spezifischen Anwendungsbereiche und die Unterschiede zu GPUs zu betrachten.

Ihr Wartungsspezialist im DataCenter

Durch Jahrzehnte lange Erfahrung wissen wir worauf es in Ihrem Data Center ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Funktionen und Einsatzgebiete von TPUs vs. GPUs

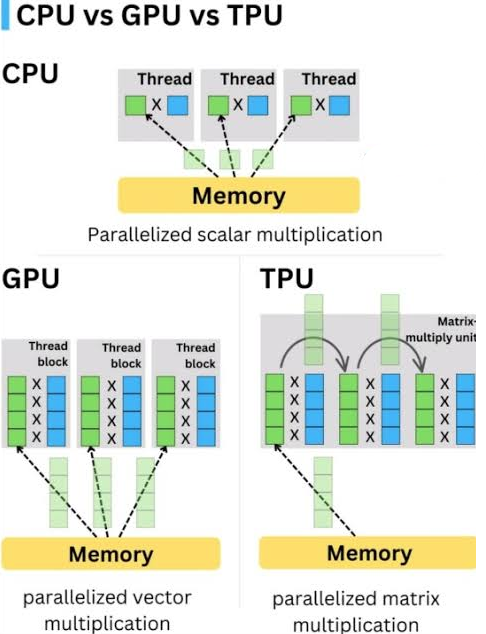

TPUs sind anwendungsspezifische integrierte Schaltungen (ASICs), die von Google speziell für neuronale Netze und maschinelles Lernen entwickelt wurden. Im Gegensatz zu GPUs, die ursprünglich für die Grafikverarbeitung konzipiert wurden, sind TPUs für Tensorberechnungen optimiert, welche die Grundlage moderner Deep-Learning-Algorithmen bilden. Ihre Architektur ist auf die Matrixmultiplikation zugeschnitten, eine Operation, die in neuronalen Netzen von zentraler Bedeutung ist. Dies ermöglicht es ihnen, große Datenmengen und komplexe Netzwerke effizient zu verarbeiten.

GPUs hingegen sind vielseitige Co-Prozessoren, die sich im Laufe der Zeit von reinen Grafikbeschleunigern zu leistungsstarken Werkzeugen für eine Vielzahl von Rechenaufgaben entwickelt haben, einschließlich KI und Deep Learning. GPUs können Probleme in kleinere Teilprobleme aufteilen und diese gleichzeitig lösen, was sie für parallele Verarbeitung ideal macht. Ihre Architektur mit vielen kleinen, effizienten Verarbeitungskernen eignet sich gut für Aufgaben, die sich in unabhängige Unteraufgaben aufteilen lassen, wie Rendering, Gaming und KI.

GPUs sind vielseitiger einsetzbar und unterstützen eine breitere Palette von Machine-Learning-Frameworks wie TensorFlow, PyTorch, Keras und Caffe. Sie bieten eine höhere Flexibilität in Bezug auf die Anpassung und Optimierung und können sowohl in On-Premise- als auch in Cloud-Umgebungen eingesetzt werden. Ihre breitere Verfügbarkeit macht sie für viele Entwickler zugänglicher als TPUs, die primär in der Google Cloud Platform (GCP) angeboten werden.

Die Entwicklungsumgebung für TPUs ist enger mit TensorFlow verbunden, Googles Open-Source-Framework für maschinelles Lernen. Google stellt umfangreiche Dokumentationen und Ressourcen zur Verfügung, um die Nutzung von TPUs mit TensorFlow zu vereinfachen. GPUs hingegen profitieren von einer starken Community-Unterstützung und umfangreichen Bibliotheken wie CUDA, cuDNN und RAPIDS.

TPUs können GPUs bei Deep Learning übertreffen

Obwohl sowohl GPUs als auch TPUs für KI-Anwendungen verwendet werden können, gibt es entscheidende Unterschiede in ihrer Leistung und Eignung für bestimmte Aufgaben. TPUs sind auf Tensorberechnungen spezialisiert und können GPUs bei bestimmten Deep-Learning-Aufgaben übertreffen. Beispielsweise benötigt das Training eines ResNet-50-Modells auf einem CIFAR-10-Datensatz auf einer Google Cloud TPU v3 nur 15 Minuten, während eine NVIDIA Tesla V100 GPU dafür 40 Minuten benötigt.

Im Allgemeinen sind TPUs auch energieeffizienter als GPUs, wobei die Leistungsaufnahme der Google Cloud TPU v3 mit 120–150 Watt pro Chip angegeben wird, während eine Tesla V100 250 Watt und eine A100 400 Watt verbraucht. Googles neueste Trillium-TPU ist noch einmal deutlich energieeffizienter.

Konkrete Anwendungsfälle von TPUs und GPUs

Die Anwendungsfälle für TPUs und GPUs sind vielfältig. Google setzt TPUs stark in seinen eigenen Produkten wie Google Search, Google Photos und Google Translate ein, wo hohe Durchsatzraten und geringe Latenzzeiten erforderlich sind. OpenAI nutzt GPUs für das Training seiner groß angelegten KI-Modelle wie GPT-3. Waymo, ein Unternehmen für selbstfahrende Autos von Alphabet, verwendet TPUs für die Echtzeitverarbeitung von Sensordaten. Microsoft integriert GPUs in seine Produktivitätstools und Cloud-Services.

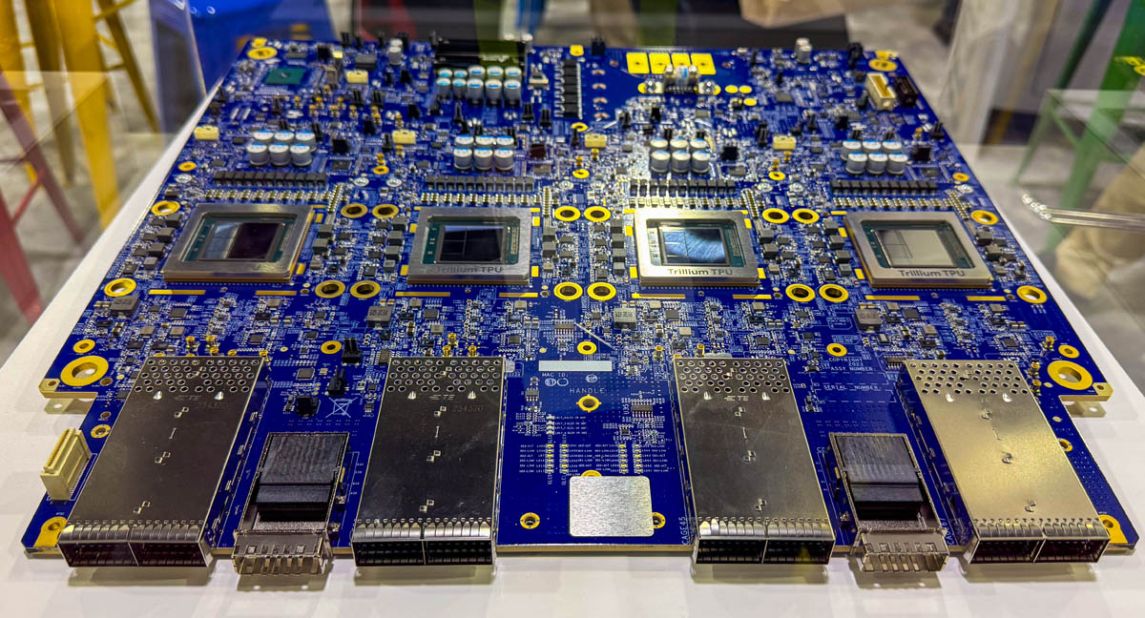

Google hat mehrere Generationen von TPUs entwickelt, jede mit verbesserten Funktionen und Leistungen. Die sechste Generation, Trillium, wurde im Mai 2024 vorgestellt und ist seit Dezember 2024 allgemein verfügbar. Laut Google bietet Trillium eine 4,7-fache Steigerung der Rechenleistung pro Chip im Vergleich zur TPU v5e und eine 67prozentige Steigerung der Energieeffizienz. Diese Fortschritte sind entscheidend, um mit der wachsenden Nachfrage nach KI-Rechenleistung Schritt zu halten.

Insgesamt ist davon auszugehen, dass Google TPUs durch ihre Spezialisierung auf Tensorberechnungen und ihre hohe Energieeffizienz eine ernstzunehmende Konkurrenz für NVIDIA darstellen. Insbesondere in den Bereichen Deep Learning und Large Language Models (LLMs) bieten TPUs eine attraktive Alternative zu GPUs.

Die Entwicklung von immer leistungsfähigeren TPUs verdeutlicht, dass Google seine Position im KI-Hardwaremarkt festigen möchte. Dennoch ist der Markt dynamisch, und die wechselseitige Konkurrenz und Innovation von NVIDIA, AMD, Intel und Google wird die Zukunft der KI-Hardware maßgeblich beeinflussen.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Project Stargate: 64.000 Nvidia GB200 GPUs werden in texanischem Rechenzentrum installiert

Das Project Stargate nimmt Fahrt auf: Die geplante Installation von 64.000 hochmodernen Nvidia GB200 Grafikprozessoren im Stargate Rechenzentrum in

Microsoft investiert in indische Aufforstung: 1,5 Millionen Tonnen CO2-Entnahme über 30 Jahre

Microsoft beteiligt sich an einem Aufforstungsprojekt in Indien und will damit eine CO2-Entnahme von 1,5 Millionen Tonnen in 30

#11 KI und Tech To Go – Der Praxis-Pitch

Im Fokus: Carbon Capture Methoden - Neue KI-Modelle - Richtungswechsel bei Deepmind und Microsofts Data Boundary Warum CCS

Zum Inhalt springen

Zum Inhalt springen